- 首页

-

产品中心

产品中心

覆盖数据实时处理与智能分析全生命周期

- 数智一体化交付

- 云能平台 AI+Data系列一体机

- 组网系列

- GPU Direct 和RDMA

- 解决方案

- 生态合作

- 产品试用

- 新闻中心

- 关于我们

发布时间:2023-06-14 | 阅读:

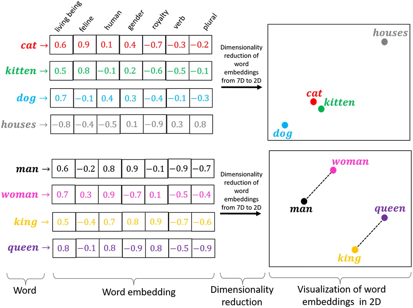

近日,柏睿数据推出向量存储查询引擎(Rapids VectorDB)和 LLMOps 平台,收获诸多行业人士的关注。尤其是柏睿向量存储查询引擎的应用与价值备受青睐。 由于在训练时训练语料的限制,最终产生的LLM往往只具备通用知识,而不具备特定垂直领域的知识,尤其是企业内部信息。 如果构建具备特定垂直领域知识的LLM,需要将特定垂直领域的知识作为新的语料来微调通用大模型,不仅耗费大量算力,而且每次信息的更新都需要重新进行模型训练,还无法保证结果的准确性。 另一方面,可以将特定垂直领域的知识作为提示(prompt)输入给通用大模型,由此得到准确的结果。但由于LLM对提示词的长度有限制,其可以获取的信息非常有限,难以记住全部的知识信息,因此无法回答垂直领域的问题。 将 Rapids VectorDB 作为通用大模型外部的信息源,可以为通用大模型提供专用数据和知识、历史知识和经验,而无需重新训练,即可很好地解决通用大模型专业知识深度不足、内容时效性差的问题。 柏睿向量存储查询引擎Rapids VectorDB基于具有完全自主知识产权的全内存分布式数据库RapidsDB,采用向量嵌入技术,有力支持数据的向量化储存和向量索引。 RapidsDB的数据联邦机制可以有效支持结构化数据和向量数据的存储与查询,全内存分布式架构与大规模并行计算引擎则使其具备了高性能、高可用与扩展的特点,可实现对向量的高效检索。 向量嵌入(vector embedding)是一种将非数值的词语或符号编码成数值向量的技术,是自然语言处理与深度学习中常用的预处理技术。柏睿数据采用向量嵌入技术,能够将文本向量化,并将其与向量数据库中存储的海量向量进行相似度搜索与匹配,通过计算两个向量之间的距离来判断向量的相似度,以实现企业业务场景中的智能化应用需求,如语义搜索和知识问答,对图像、音频、视频等非结构化数据进行相似度搜索,推荐排序,异常检测等功能。 柏睿数据Rapids VectorDB,基于大语言模型(LLM)实现特定垂直领域的知识问答功能的技术思路如下: 首先提取原始文档的文本,将这些文本进行分割与切块,将文本块放入向量嵌入模块,生成文本向量,并存储于 Rapids VectorDB 中。 用户提出的问题经由向量嵌入模块,转为向量。 将转为向量的问题作为查找项,进入Rapids VectorDB中查找与之相似度最高的文本块。 用户提出的问题与查找到的相关知识将被组合并被LLM处理,最终返回用户所需要的答案。 目前,柏睿向量存储查询引擎基于LLM的应用场景还在不断深化与升级。依托LLMOps平台、Rapids AI等柏睿数据新一代全栈数据智能产品体系,柏睿数据为企业AI大模型发展提供从数据采集、存储、计算分析到模型训练、部署、应用的全生命周期解决方案,助力企业高效、安全、轻松地通过个性化的AI大模型构筑匹配自身行业垂直领域的数字化、智能化能力。